Robots.txt Dosyası Nedir ve WordPress’te Ne İşe Yarar?

Robots.txt dosyası, WordPress sitenizde arama motoru botlarının hangi sayfalara erişebileceğini ve hangilerini taramaması gerektiğini belirlemek için kullanılır. Bu dosya, bir nevi dijital trafik polisi gibi davranır; arama motorlarına sitenizin hangi bölümlerini dikkate alması gerektiğini ve hangilerinden uzak durmasını istediğinizi bildirir. WordPress altyapısı, varsayılan olarak otomatik bir robots.txt sunar; ancak bu varsayılan yapı, çoğu zaman spesifik ihtiyaçlara göre yetersiz kalır.

Robots.txt dosyasının temel işlevi, arama motoru tarama davranışını yönlendirmektir. Bu sayede hem tarama bütçesi optimize edilir hem de arama motorlarının gereksiz veya tekrarlayan içerikler üzerinde zaman harcaması engellenir. Özellikle büyük sitelerde, robotların siteyi verimli taraması için bu dosya ciddi önem taşır.

WordPress üzerinde dinamik olarak üretilen içerikler, otomatik URL oluşturma yapıları ve taksonomi sayfaları nedeniyle robots.txt dosyasının iyi yapılandırılması gereklidir. Aksi halde, botlar gereksiz veya SEO açısından değersiz sayfaları tarayarak sitenin genel görünürlüğünü olumsuz etkileyebilir.

WordPress’te Robots.txt Dosyası Nasıl Oluşturulur?

WordPress’te robots.txt dosyası oluşturmak için kök dizinde manuel bir dosya oluşturulabilir ya da SEO eklentileri üzerinden sanal dosya yönetimi tercih edilebilir. WordPress’in kendisi fiziksel bir robots.txt dosyası barındırmaz; bu dosya genellikle sanal olarak, sistem tarafından otomatik şekilde sunulur. Ancak gelişmiş yapılandırmalar gerektiğinde manuel müdahale şarttır.

Manuel yöntemle robots.txt oluşturmak için FTP veya dosya yöneticisi kullanılarak /public_html ya da /www dizinine düz metin formatında bir dosya oluşturulmalıdır. Dosya adı kesinlikle robots.txt olmalıdır. UTF-8 kodlaması kullanılmalı ve dosya sonunda BOM olmamalıdır. Bu dosyada yapılacak her satırın, arama motorları tarafından hassasiyetle işleneceği unutulmamalıdır.

Alternatif olarak, Yoast SEO, All in One SEO ya da Rank Math gibi eklentiler, sanal robots.txt dosyası oluşturma ve düzenleme imkânı sunar. Bu yöntem, teknik bilgiye sahip olmayan kullanıcılar için daha uygundur ancak bazı sınırlamalar içerir; örneğin, fiziksel dosyada yapılabilecek ince ayarların tamamı bu arayüzler üzerinden mümkün olmayabilir.

Robots.txt Dosyasında Hangi Kurallar Bulunmalı?

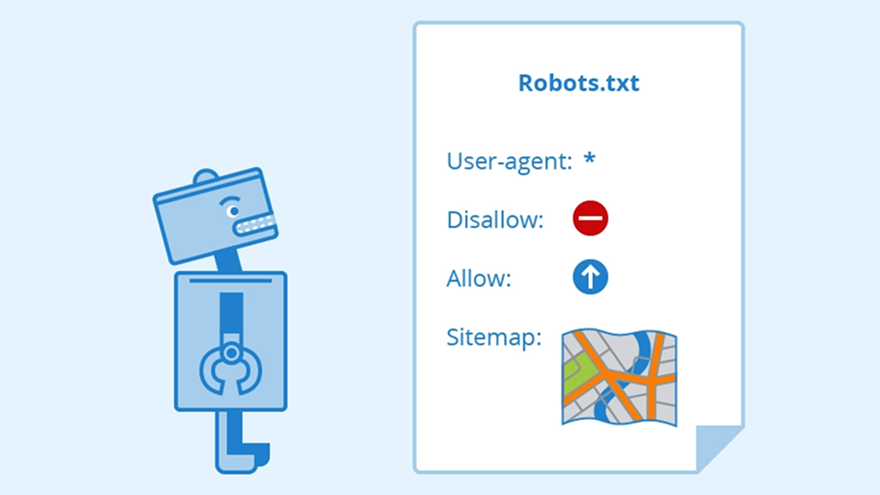

Robots.txt dosyasında, arama motorlarına hangi kullanıcı ajanlarının hangi sayfalara erişeceği ya da erişemeyeceği kurallarla belirlenir. Bu kurallar User-agent, Disallow, Allow ve Sitemap komutlarıyla tanımlanır. Kullanıcı ajanları, belirli arama motorlarını ifade eder ve * joker karakteri tüm botları kapsar.

WordPress sitelerinde genellikle aşağıdaki gibi özel yapılandırmalar tercih edilir:

Disallow: /wp-admin/komutu ile yönetici paneli taramadan hariç tutulur.Allow: /wp-admin/admin-ajax.phpifadesi, AJAX çağrılarının engellenmesini önler.Disallow: /?s=ile site içi arama sonuçları engellenir, çünkü bu sayfalar yinelenen içerik üretir.

Bu kurallar, genellikle SEO verimliliğini artırmak ve arama motorlarının öncelikli sayfaları taramasını sağlamak için kullanılır. Robots.txt içeriği, sitenin yapısına göre şekillenmelidir; standart yapıların her siteye uygun olacağı varsayımı yanlış olur.

SEO Uyumlu Robots.txt Dosyası Örneği WordPress İçin

SEO uyumlu bir robots.txt örneği, hem gereksiz taramaları engeller hem de arama motorlarının site haritasını net şekilde bulmasını sağlar. WordPress için optimize edilmiş bir yapı şu şekilde olabilir:

makefileCopyEditUser-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Disallow: /?s=

Disallow: /tag/

Disallow: /author/

Sitemap: https://example.com/sitemap_index.xml

Bu yapı, yönlendirilmemiş taksonomi sayfalarını ve yazar arşivlerini dışarda bırakırken AJAX isteklerinin çalışmasına izin verir. Ayrıca, Google ve diğer botlara site haritasının tam URL’ini verir. Site haritası linkinin robots.txt’ye eklenmesi, Google’ın dizinleme sürecinde bu URL’ye öncelik tanımasını sağlar.

Robots.txt Dosyasına Hangi Sayfalar Eklenmeli veya Hariç Tutulmalı?

Robots.txt dosyasına, kullanıcı deneyimi ve SEO açısından değersiz olan sayfalar hariç tutulmalı, ancak önemli içerikler her zaman erişime açık bırakılmalıdır. WordPress’te bu, genellikle taksonomi ve arama sonuçları gibi tekrarlayan içeriklerle ilgilidir.

Hariç tutulması önerilen sayfa türleri şunlardır:

/wp-login.phpve/wp-admin/gibi yönetimsel alanlar/?s=gibi arama sonuçları sayfaları/tag/,/author/gibi düşük SEO değeri taşıyan arşiv sayfaları

Erişime açık kalması gereken sayfalar ise şunlardır:

- İçerik sayfaları (örneğin blog yazıları, kategori açıklamaları)

- Medya dosyaları

- Sitemap bağlantıları

Buradaki temel prensip, Google’ın erişmesini istediğiniz her şeyin açık olması; erişmesini istemediğiniz her şeyin ise net bir şekilde Disallow komutu ile engellenmesidir. Ancak bu engelleme, içeriğin dizine eklenmesini değil yalnızca taranmasını kısıtlar.

WordPress’te Robots.txt Dosyasını Nereden Düzenleyebilirim?

WordPress’te robots.txt dosyasını düzenlemek için ya FTP ile fiziksel dosya üzerinde çalışmanız ya da SEO eklentileri üzerinden sanal dosyayı değiştirmeniz gerekir. Fiziksel dosya düzenlemesi genellikle /public_html/robots.txt yolunda yapılır. Bu yöntem, daha hassas kontrol gerektiren durumlar için uygundur.

Yoast SEO gibi eklentiler ise sanal bir arayüz sunar. SEO > Araçlar > Dosya Düzenleyici bölümüne giderek robots.txt içeriğini doğrudan değiştirebilirsiniz. Ancak bu düzenleme geçici olabilir; bazı önbellek eklentileri veya güvenlik yapılandırmaları, değişikliklerin kalıcılığını etkileyebilir.

Dikkat edilmesi gereken bir nokta, hem fiziksel hem sanal robots.txt dosyalarının aynı anda kullanılmasının çakışmalara neden olabileceğidir. Fiziksel dosya varsa, sistem onu öncelikli kabul eder.